Atlas集成外部组件—集成Hive、HBase、Kafka

6# 账户密码 admin admin1232、集成HBase=========1# 编辑 hbase-site.xml2cd /etc/hbase/conf3vi hbase-site.xml45# add for hbase regist atlas hook6# design by liziba 2021/02/2278hbase.coprocessor.master.classes9org

6# 账户密码 admin admin123

看到新导入的database 则证明历史元数据导入成功

2、集成HBase

=========

Atlas HBase hook与HBase master注册为协处理器。在检测到对HBase名称空间/表/列族的更改时,Atlas Hook过Kafka通知更新Atlas中的元数据。按照以下说明在HBase中设置Atlas Hook:

1# 编辑 hbase-site.xml

2cd /etc/hbase/conf

3vi hbase-site.xml

4

5# add for hbase regist atlas hook

6# design by liziba 2021/02/22

7

8 hbase.coprocessor.master.classes

9 org.apache.atlas.hbase.hook.HBaseAtlasCoprocessor

10

查看元数据

1# 切换到hadoop

2su - hadoop

3# 创建hbase table

4hbase shell

5

6create ‘t1’, ‘cf1’

再次查看元数据

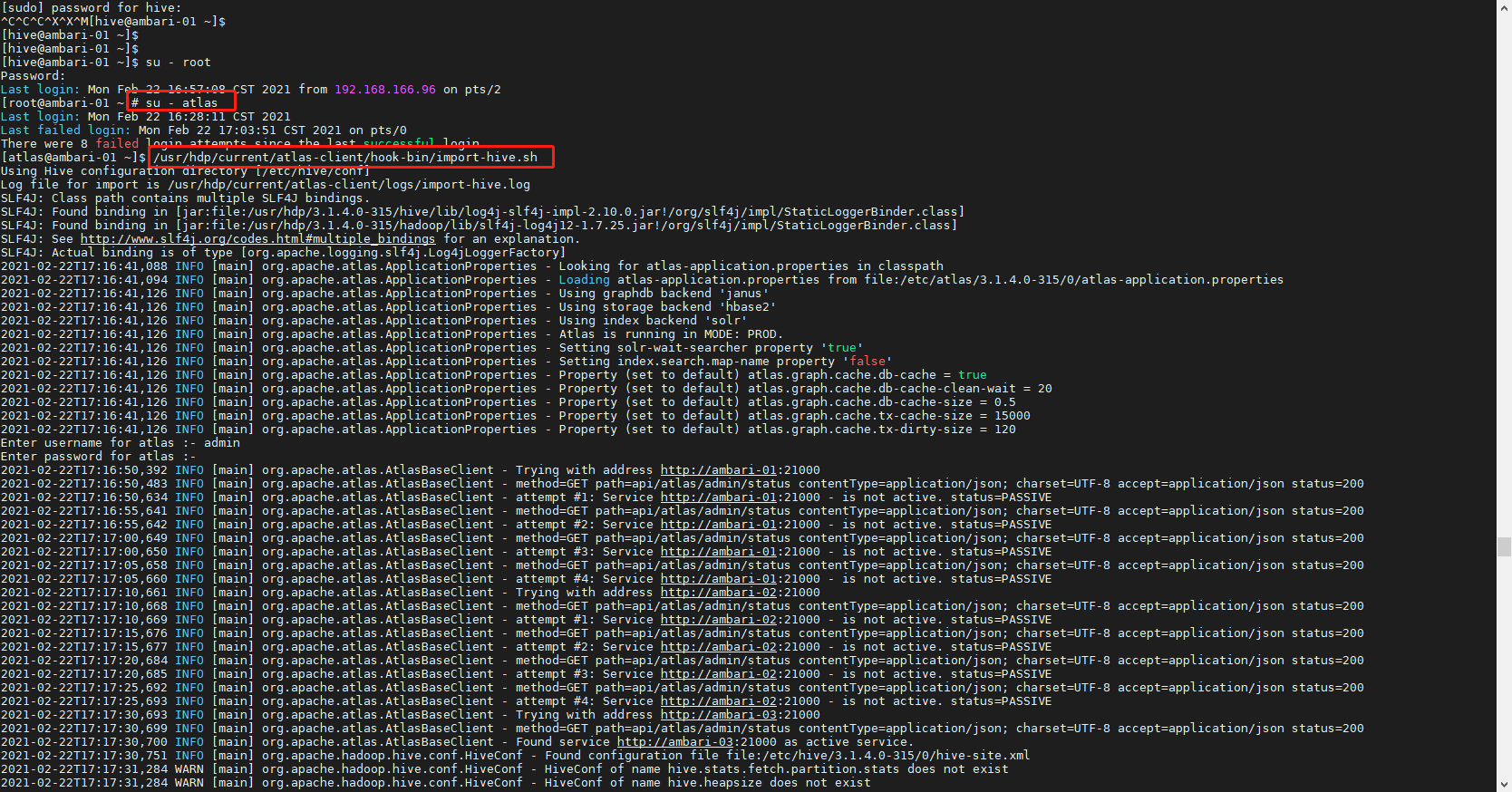

2.1历史元数据导入

同样,HBase也会在Atlas上线之前早就上线了,所以需要同步历史上的元数据。

注意:一定要进入atlas用户,因为Atlas的Linux管理账户是atlas,其他账户下可能会报没有权限的错误。

1sudo su - atlas

2/usr/hdp/current/atlas-client/hook-bin/import-hbase.sh

3# 密码 admin admin123

再次查看元数据

3、集成Kafka

=========

3.1Bug规避

HDP3.1有一个Bug,安装Atlas时不会自动安装atlas-kafka-hook。

3.1.1 发现bug

1# 进入hook-bin目录

2cd /usr/hdp/current/atlas-client/hook-bin

可以看到并没有Kafka的import脚本。

然后再登录HDP yum源所在节点(安装Ambari时使用的Httpd)

1cd /var/www/html/HDP/centos7/3.1.4.0-315/atlas

2ls -l

上图中我们可以看到atlas-kafka插件包是提供了的,接下来可以看看该插件在Kakfa节点上是否安装。

登录任意Kafka节点:

1yum list atlas-metadata_3_1_4_0_315-kafka-plugin

并未安装atlas-metadata_3_1_4_0_315-kafka-plugin

结论 HDP-3.1.4.0中,Ambari安装Atlas时没有自动安装atlas-metadata_3_1_4_0_315-kafka-plugin,这是一个bug

3.1.2 规避bug

在 Kafka的任意Clien节点安装atlas-metadata_3_1_4_0_315-kafka-plugin: ambari-02 167

1sudo yum install -y atlas-metadata_3_1_4_0_315-kafka-plugin

安装完修改下执行权限

1sudo chown atlas:hadoop /usr/hdp/current/atlas-client/hook-bin/import-kafka.sh

2sudo chown atlas:hadoop /usr/hdp/current/atlas-client/logs/

3.1.2 集成原理与局限性

Atlas只提供一个批量导入元数据到Atlas的工具,原理是通过kafka.utils.ZkUtils获取Topic的元数据信息并写入Atlas。

Atlas没有提供Kafka Hook,所以不能实时采集Kafka的元数据,需要定期调度批量导入元数据的脚本。

3.1.3 历史元数据导入

Kafka可能在Atlas上线之前早就上线了,所以需要同步历史上的元数据

查看kakfa_topic 元数据 初始无元数据

1# 在安装kafka插件服务器执行初始化脚本

2su - atlas

3/usr/hdp/current/atlas-client/hook-bin/import-kafka.sh

再次查看元数据

尾声

如果你想成为一个优秀的 Android 开发人员,请集中精力,对基础和重要的事情做深度研究。

对于很多初中级Android工程师而言,想要提升技能,往往是自己摸索成长,不成体系的学习效果低效漫长且无助。 整理的这些架构技术希望对Android开发的朋友们有所参考以及少走弯路,本文的重点是你有没有收获与成长,其余的都不重要,希望读者们能谨记这一点。

这里,笔者分享一份从架构哲学的层面来剖析的视频及资料分享给大家梳理了多年的架构经验,筹备近6个月最新录制的,相信这份视频能给你带来不一样的启发、收获。

PS:之前因为秋招收集的二十套一二线互联网公司Android面试真题 (含BAT、小米、华为、美团、滴滴)和我自己整理Android复习笔记(包含Android基础知识点、Android扩展知识点、Android源码解析、设计模式汇总、Gradle知识点、常见算法题汇总。)

架构篇

《Jetpack全家桶打造全新Google标准架构模式》

《Android学习笔记总结+移动架构视频+大厂面试真题+项目实战源码》,点击传送门,即可获取!

网公司Android面试真题 (含BAT、小米、华为、美团、滴滴)和我自己整理Android复习笔记(包含Android基础知识点、Android扩展知识点、Android源码解析、设计模式汇总、Gradle知识点、常见算法题汇总。)

[外链图片转存中…(img-KAWsAJyo-1714795259325)]

架构篇

《Jetpack全家桶打造全新Google标准架构模式》

[外链图片转存中…(img-gcULo8Uj-1714795259326)]

《Android学习笔记总结+移动架构视频+大厂面试真题+项目实战源码》,点击传送门,即可获取!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)